Alors que l’IA est de plus en plus utilisée par les patients pour connaître leur état de santé, une nouvelle étude britannique déconseille de recourir systématiquement à cet outil car peu fiable. Mais, si cette technologie a tendance à donner de fausses réponses, le problème ne vient pas toujours d’elle. Selon les chercheurs, les utilisateurs ne savent pas tous comment bien la questionner.

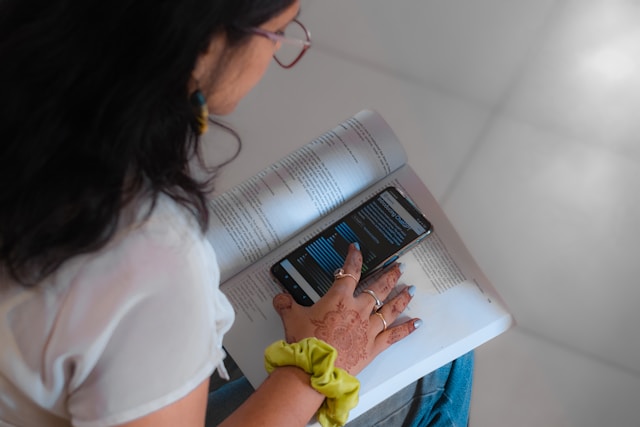

Aujourd’hui, nous utilisons l’intelligence artificielle au quotidien pour presque tout : travail, recherche, loisirs, etc. Nous nous en servons même pour connaître notre santé car il existe des chatbot entraînés pour donner des avis médicaux. Ces outils peuvent notamment faire des diagnostics, mieux qu’un médecin. Comme on a pu le constater récemment avec ChatGPT qui a sauvé la vie d’une Américaine atteinte d’un cancer. Le chatbot a identifié précisément la maladie, en un clic, après que plusieurs médecins ont donné de faux diagnostics pendant plus d’un an.

1 Américain sur 6 utilise l’IA pour interroger sa santé

Fort des conseils médicaux globalement justes de l’IA, de nombreuses personnes ont aujourd’hui recours à cette technologie en cas de soucis. Aux États-Unis, 1 personne sur 6 interroge ainsi un chatbot, au moins une fois par mois, pour connaître son état de santé. D’ailleurs, les médecins aussi s’en servent de plus en plus, ayant repéré son potentiel. Au Royaume-Uni, par exemple, 20 % des praticiens utilisent cette innovation comme une aide ou un assistant. Pourtant, une nouvelle étude de l’Oxford Internet Institute nous conseille de nous méfier de l’intelligence artificielle dans le domaine médical. Elle affirme que l’IA n’est pas fiable en raison des mauvaises analyses ou des recommandations dangereuses qu’elle peut faire.

1 300 personnes ont pris part à une étude sur les chatbots médicaux

Pour cette enquête, les chercheurs d’Oxford ont recruté environ 1 300 personnes au Royaume-Uni et leur ont soumis des scénarios médicaux rédigés par un groupe de médecins. Les participants devaient identifier des problèmes de santé potentiels dans ces situations fictives, et utiliser leurs propres méthodes (par exemple des recherches en ligne) ou des chatbots pour déterminer les actions possibles (consulter un médecin ou se rendre à l’hôpital). Concernant les outils d’IA, ils pouvaient en utiliser trois : GPT-4o d’OpenAI (concepteur de ChatGPT), Command R+ de Cohere et Llama 3 de Meta.

De bonnes réponses mais aussi de mauvaises recommandations

Les résultats indiquent que l’intelligence artificielle réduit considérablement les chances d’identifier le bon problème de santé. Pire, la technologie a tendance à sous-estimer la gravité de la maladie. Par ailleurs, les participants à l’étude ont eu du mal à obtenir des conseils de santé utiles de sa part. « Les réponses reçues comportaient souvent de bonnes et de mauvaises recommandations », a souligné Adam Mahdi, directeur des études supérieures à l’Oxford Internet Institute et co-auteur de l’étude. Selon le chercheur, « les méthodes d’évaluation actuelles des chatbots ne reflètent pas la complexité des interactions avec les utilisateurs humains. ».

Les utilisateurs ne savent pas toujours guider l’IA

Adam Mahdi note cependant que le peu de fiabilité de l’IA n’est pas entièrement de son fait (de la nature du système). En effet, les chercheurs britanniques ont également constaté « une rupture de communication bilatérale ». En d’autres termes, les utilisateurs ne savaient pas quels détails fournir et omettaient régulièrement des informations cruciales. Ce qui aboutissait à des recommandations de mauvaise qualité du côté des chatbots. Pour les chercheurs, il est donc crucial de former les patients, mais aussi les médecins, à l’utilisation efficace des solutions d’IA.

L’IA peut se spécialiser grâce à un entraînement dans un domaine précis de la médecine

Face aux risques d’avis médicaux erronés, le Dr Mahdi juge important que les algorithmes soient « testés en profondeur avant d’être utilisables en toute sécurité par le public. ». De son côté, l’American Medical Association avait déjà déconseillé aux médecins de recourir aux chatbots comme ChatGPT pour les aider à prendre des décisions cliniques. L’organisation estime que ces outils ne peuvent remplacer un professionnel de santé. Pourtant, certains experts pensent qu’une IA bien entraînée dans une spécialité de la médecine peut devenir cardiologue, dermatologue et autres.